Acharam que a Apple já tinha dado explicações o suficiente sobre as suas novas ferramentas contra abuso e pornografia infantil? Pois acharam errado: hoje, o TechCrunch publicou uma entrevista com Erik Neuenschwander, chefe de privacidade da empresa, justamente para mais uma rodada de esclarecimentos sobre o tema.

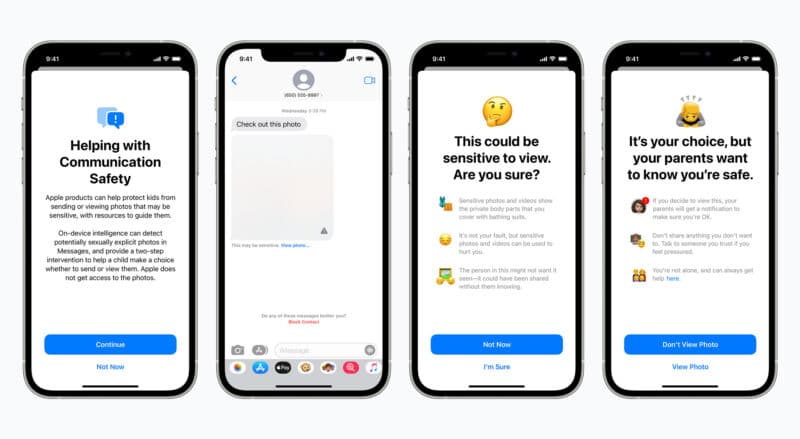

O executivo foi perguntado sobre possíveis confusões entre dois dos recursos anunciados — as ferramentas de proteção no iMessage, destinadas apenas a menores de idade e realizadas somente com técnicas de inteligência artificial, e o escaneamento de hashes nas fotos que você sincronizará com o iCloud.

SegundoNeuenschwander, os dois recursos fazem parte de uma mesma iniciativa maior contra o abuso infantil — que pode, potencialmente, proteger não apenas crianças que já foram vítimas desses crimes horrendos, mas também crianças que podem ser possíveis alvos de futuras ocorrências.

São dois sistemas que fazem parte de um grupo maior, junto às novas intervenções que chegarão à Siri e ao Spotlight. Por mais importante que seja identificar colecionadores de material conhecido de pornografia infantil conforme este material é armazenado no iCloud, também é importante ir além dessa situação que já é horrível. A detecção de CSAM (Material de Abuso Sexual Infantil) significa que já há material do tipo no processo de identificação, e que este material está sendo compartilhado amplamente — revitimizando crianças para além dos abusos pelos quais elas tiveram de passar para a criação daquele conteúdo.

Então acho que este é um passo importante, mas é importante também fazer coisas que intervenham antes, quando as pessoas estão entrando nesta área problemática e prejudicial, ou se há abusadores tentando aliciar ou trazer crianças para situações nas quais o abuso pode acontecer. Os recursos do iMessage e os da Siri e da busca lidam justamente com essa parte do processo.

O TechCrunch também perguntou, naturalmente, sobre as preocupações de privacidade geradas pelo sistema de escaneamento de imagens. Questionado se governos poderiam criar novas categorias de conteúdo considerado ilegal ou “inaceitável”, potencialmente prejudicando a privacidade do usuário,Neuenschwander respondeu o seguinte:

Em primeiro lugar, o sistema está sendo lançado apenas nos Estados Unidos, para contas do iCloud, então essas hipóteses parecem trazer países genéricos ou outros países que não são os EUA. As pessoas parecem concordar que a lei dos EUA não dá ao governo esse tipo de capacidade.

Ainda assim, mesmo no caso de alguma tentativa de mudar o sistema, temos algumas proteções embutidas que o tornam não muito útil para identificar pessoas com imagens de outros tipos. A lista de hashes está gravada no sistema operacional, esse sistema é global e nós não temos a capacidade de lançar atualizações para usuários específicos, portanto a lista de hashes será compartilhada entre todos os usuários quando o sistema for ao ar.

Além disso, o sistema requer que o limite de imagens seja excedido, portanto tentar buscar uma única imagem no dispositivo de uma pessoa ou um grupo não funcionará, porque o sistema não dá à Apple qualquer conhecimento sobre fotos individuais armazenadas no dispositivo.

Para terminar, o sistema tem um estágio de análise humana, no qual, se uma conta é marcada com uma possível coleção de CSAM, uma equipe da Apple analisará o conteúdo para verificar se as imagens são de fato material CSAM antes de fazer qualquer denúncia às autoridades. Portanto, qualquer hipótese de mau uso do sistema envolve uma série de desvios, incluindo um cenário no qual a Apple muda seu processo interno para denunciar material que não é ilegal.

Um adendo: sobre a questão de o sistema ser lançado inicialmente nos EUA (e a argumentação de que as leis do país protegeriam o seu funcionamento), vale conferir essa thread de Matt Tait, chefe de operações da Corellium e ex-agente do serviço de inteligência brtiânico GCHQ. Nas postagens, Tait traz uma hipótese interessante de que o sistema poderia representar uma infração à Quarta Emenda da Constituição dos EUA, e as provas obtidas pelo NeuralHash poderiam ser invalidadas pelas cortes do país.

Voltando à entrevista, Neuenschwander confirmou, ainda, que usuários que não queiram se submeter ao sistema poderão simplesmente desligar a Biblioteca de Fotos do iCloud — neste caso, as imagens não serão analisadas, e o dispositivo sequer gerará hashes delas.

A entrevista completa deNeuenschwander pode ser lida aqui. E aí, opiniões?