Na última semana, o mercado de inteligência artificial (IA) foi inundado de novidades interessantes e promissoras.

O Google, por exemplo, liberou em 170 países (apenas em inglês) o aguardado Gemini, um modelo multimodal (que interage por meio de texto, áudio e vídeo) de IA generativa, que supera o desempenho do GPT-4 em alguns quesitos.

O Gemini foi desenvolvido em três tamanhos de modelo: o Ultra (que é a versão que supera o GPT-4), para tarefas mais complexas e que será disponibilizado no início de 2024), o Pro (comparável ao GPT-3.5), para a maioria das tarefas, e o Nano, que roda localmente com suporte imediato ao Pixel 8 Pro.

Já a Microsoft, com o quiprocó da briga de bastidores da OpenAI no retrovisor, anunciou uma série de bem-vindas funcionalidades no Copilot.

Dentre elas, os destaques são a possibilidade imediata de criar imagens por meio do DALL·E 3, a iminente chegada de formulação de respostas por meio do recém-lançado GPT-4 Turbo e, talvez uma das mais empolgantes para quem programa, suporte à funcionalidade Code Interpreter do ChatGPT, que permite a execução e teste de código diretamente dentro da conversa ou da pesquisa.

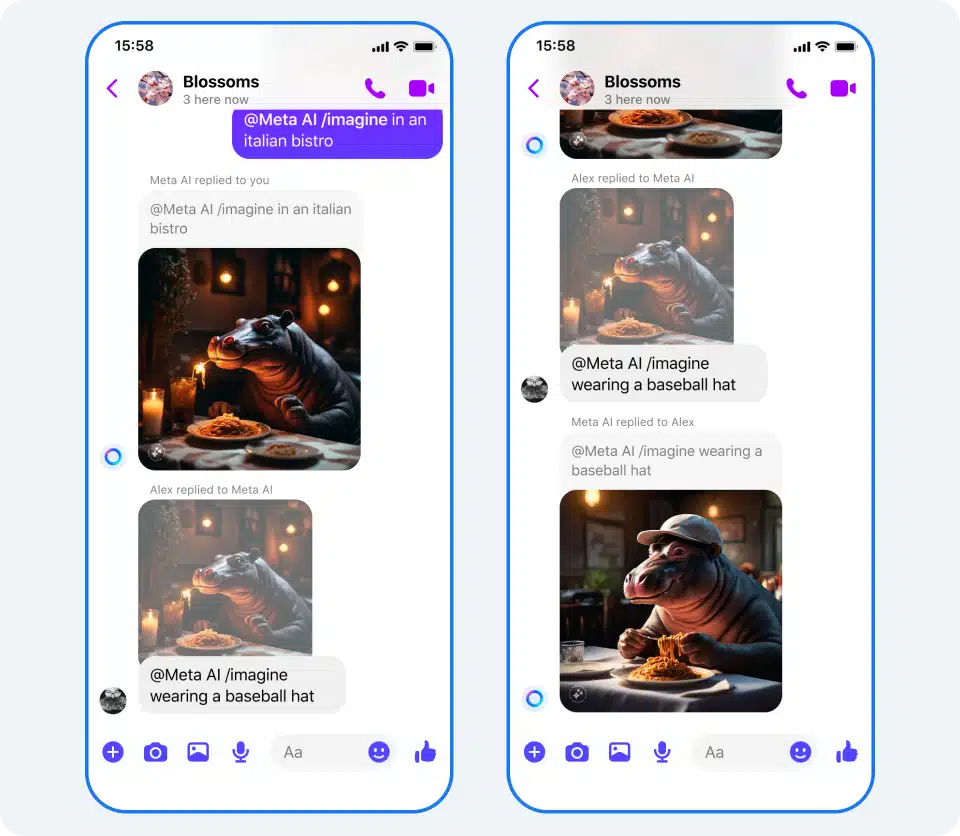

A Meta, por sua vez, fez uma série de anúncios envolvendo IA e seus produtos, incluindo acesso ao Emu (basicamente o DALL·E da Meta), integração da Meta AI (basicamente o ChatGPT da Meta) em campos de composição de texto e detalhes envolvendo segurança, incluindo a inserção de marcas d’água invisíveis em conteúdos gerados sinteticamente.

Em meio a tantas novidades bacanas, teve uma que passou despercebida por boa parte do mercado, mas que é particularmente empolgante para quem lê o MacMagazine. E essa novidade se chama MLX.

O que é o MLX?

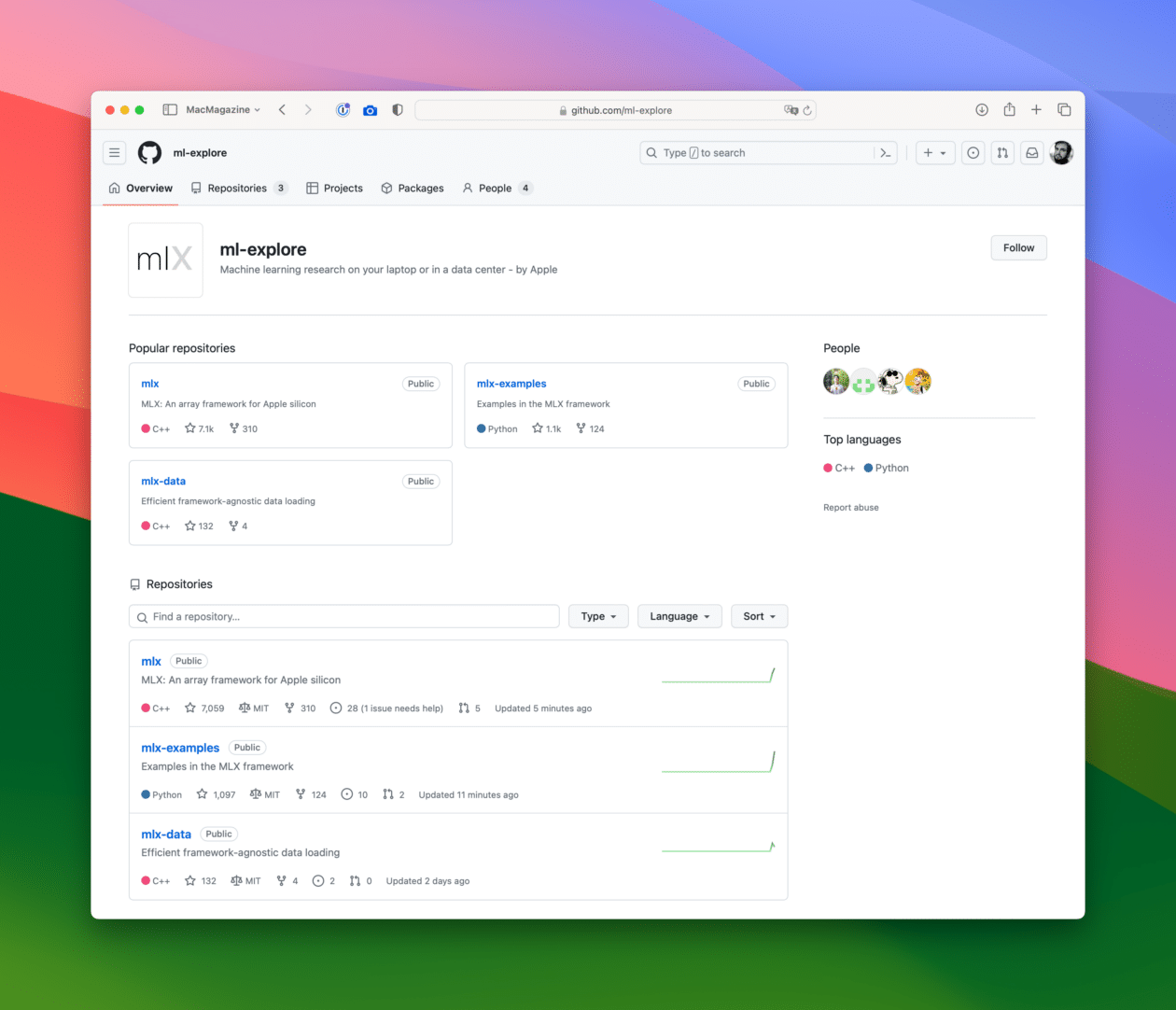

Publicado no GitHub por Awni Hannun, cientista de pesquisa de machine learning da Apple, o projeto MLX (ou ml-explore) é composto inicialmente por dois frameworks: o mlx, para machine learning em máquinas com Apple Silicon, e o mlx-data, uma biblioteca de carregamento de dados.

O projeto foi concebido inspirado em frameworks que toda a comunidade de IA vem utilizando em peso, como por exemplo o PyTorch (da Meta), o JAX (do Google) e o ArrayFire. Mais precisamente, sua estrutura é bem próxima à da biblioteca NumPy, amplamente utilizada em computação científica na linguagem Python, graças à sua baixa barreira de entrada para aprendizado, e alta versatilidade.

Um diferencial interessantíssimo do framework mlx é o fato de que a sua estrutura se baseia em um modelo unificado de memória. Na prática, isso significa que ele pode cumprir tarefas usando tanto a CPU1Central processing unit, ou unidade central de processamento. quanto a GPU2Graphics processing unit, ou unidade de processamento gráfico., sem a necessidade de copiar os dados de um lugar para outro3Nos últimos anos, o treinamento de modelos por meio de GPUs virou uma espécie de padrão quando o assunto é IA, graças à velocidade com a qual as GPUs conseguem fazer cálculos simultâneos em comparação com CPUs. A NVIDIA foi a maior beneficiada disso, tendo valorizado mais de 200% em 2023..

Dependendo da complexidade da tarefa e da forma como a Apple seguir desenvolvendo o MLX, isso pode se tornar um enorme diferencial quando o assunto for o treinamento de modelos em Macs com Apple Silicon, já que ela estará no controle de todas as variáveis dessa equação.

No caso do mlx-data, uma grande vantagem é ele funcionar com PyTorch, com JAX, e com o próprio mlx. Isso permite aos desenvolvedores uma flexibilidade de plataforma, reduzindo ainda mais o atrito inicial para sua adoção.

Por que o MLX é importante?

Esse é um dos primeiros lançamentos públicos da Apple quando o assunto é o uso de Macs por desenvolvedores para o treinamento de modelos de inteligência artificial.

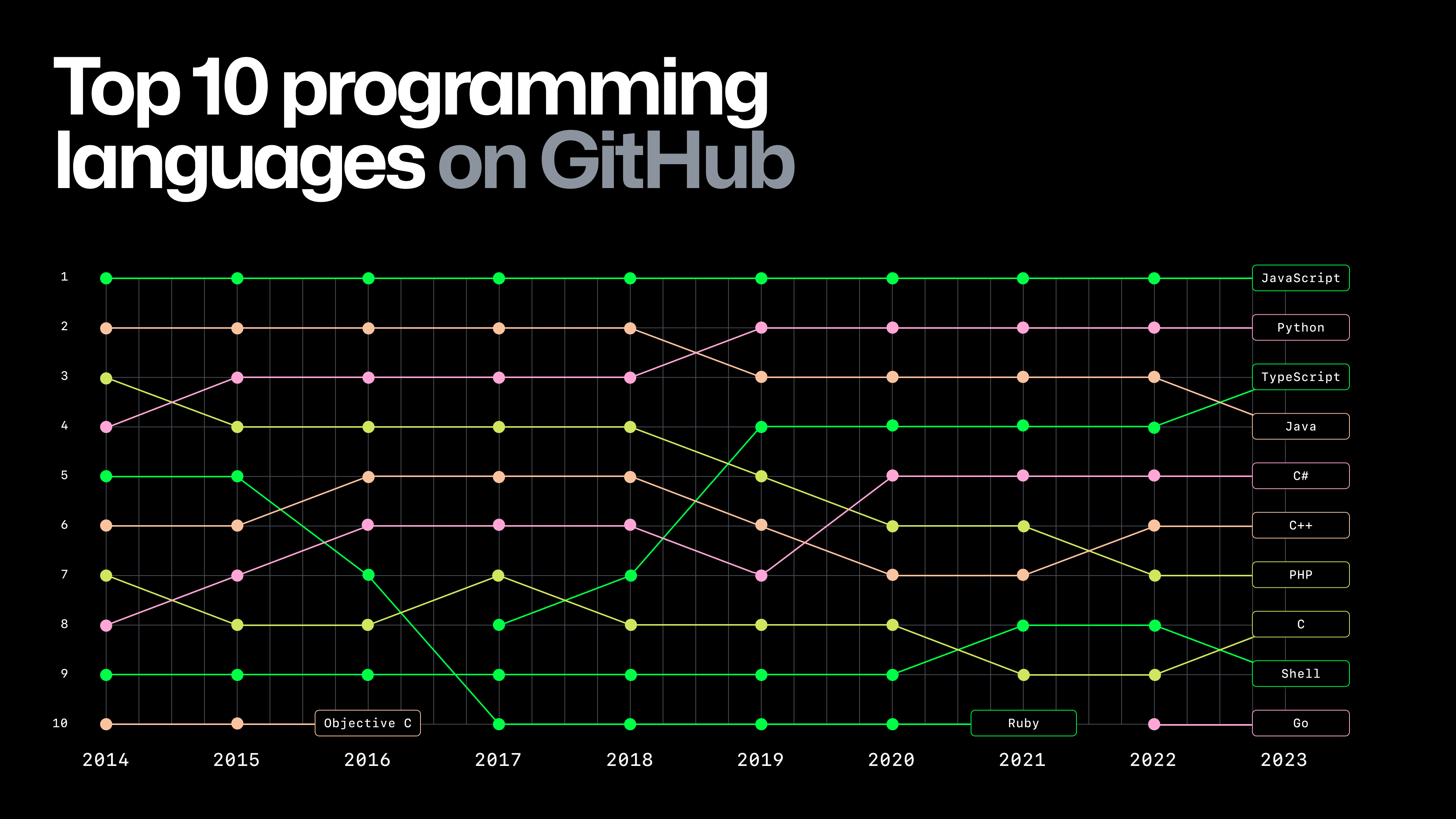

Mais importante do que isso, ao adotar o Python (além de suporte a algumas operações em C++) no MLX, a Apple mostra que não irá lutar contra a maré quando o assunto é a língua franca do desenvolvimento de IA e machine learning. Ao invés disso, disponibilizará a ferramenta na linguagem que a comunidade já utiliza, reduzindo bastante a barreira de entrada e aumentando as chances de uma rápida adoção por parte dos desenvolvedores.

Quem tem boa memória provavelmente se lembrará de que, em dezembro de 2022, a Apple já havia anunciado otimizações ao Core ML4Estrutura de aprendizado de máquina usada em todos os produtos da empresa. para utilizar o Stable Diffusion (modelo de IA generativa de imagens) em dispositivos com Apple Silicon rodando a partir do macOS 13.1 e do iOS 16.1.

O lançamento incluiu uma biblioteca em Python para converter modelos PyTorch para Core ML, além de um pacote Swift para distribuir o modelo. Na prática, isso abriu caminho para a incorporação dos modelos da Stable Diffusion em apps de iOS e macOS, o que foi uma ótima notícia para desenvolvedores.

Desta vez, a coisa vai além. Enquanto o Stable Diffusion é utilizado apenas para a geração de imagens, a novidade da última semana abre caminho para o treinamento e a adoção de múltiplas formas de IA em apps de macOS e iOS, sendo que todo o projeto pode ser desenvolvido a partir de um Mac.

O fato de a Apple não ter esperado até a WWDC24 para fazer esse anúncio é um excelente sinal e mostra que ela está com pressa para correr atrás do tempo perdido, a fim de tornar o Mac uma ferramenta tão útil para desenvolver IA quanto as que estão disponíveis no resto do mercado.

Mas e do lado da Apple?

Bem, essa é a pergunta que fica. Historicamente, a Apple sempre teve dificuldade de atrair talentos desse mercado por conta das políticas de segredos que permeiam a empresa. Somente em 2016 ela passou a permitir a publicação de artigos científicos, o que é uma prática comum e essencial para profissionais desse segmento.

Além disso, nos últimos meses, a Apple rebatizou a sua divisão de machine learning como AIML, sinalizando um aumento na abrangência da atuação que ela pretende ter5Existe uma enorme discussão semântica sobre IA e ML no mercado e, tecnicamente, muito do que chamamos de IA é, na verdade, ML. Mas como picuinhas semânticas raramente chegam a algum lugar, sigamos em frente..

Por fim, a Apple elegeu “IA generativa” como tendência do ano, dando continuidade à campanha de relações públicas que ela vem fazendo para dizer ao mercado que ela sabe que dormiu no ponto, mas que está correndo atrás do tempo perdido. Múltiplos executivos, incluindo Tim Cook, têm dado entrevistas dizendo que a Apple vem trabalhando em novidades envolvendo inteligência artificial, apesar de obviamente não dizerem exatamente o que vem por aí.

Olhando para a concorrência, a forma como a Microsoft vem adotando IA em seus produtos parece ser uma boa prévia do que poderá sair de Cupertino. Do Windows ao Office, do Bing ao GitHub, todos os produtos da Microsoft oferecem algum tipo de integração com IAs, muitas delas generativas e que têm se provado úteis no dia a dia. Até o MS Paint já ganhou funções de IA!

Já do lado do mercado de desenvolvimento, o Azure e as outras ferramentas da Microsoft vêm oferecendo possibilidades poderosíssimas para o desenvolvimento de ferramentas inteiras de IA, sem qualquer relação com o ecossistema da Microsoft. Até mesmo o ChatGPT roda na estrutura da Microsoft.

E pode ser que a Apple pretenda fazer algo assim. Digo isso porque existe um detalhe interessante a respeito do MLX: ele foi lançado por meio de espécie de organização separada da Apple, chamada ML Explore.

Com o mote “Pesquisa de aprendizado de máquina no seu laptop ou em um data center – pela Apple”, a ML Explore provavelmente lançará mais iniciativas e ferramentas no futuro. A parte do texto que diz “ou em um data center” é especialmente interessante, porque ela pode indicar que talvez a Apple tenha ambição de se tornar uma fornecedora de tecnologia para além apenas dos ecossistemas iOS/macOS, assim como a Microsoft faz com o Azure.

Paralelo a tudo isso, existe, é claro, a questão de quais ferramentas e recursos de IA a própria Apple vem desenvolvendo para adotar nos seus sistemas. Independentemente do que ela lançar, uma coisa é certa: se os desenvolvedores puderem integrar as suas próprias soluções a seja lá o que a Apple estiver desenvolvendo, talvez não estejamos tão distantes de finalmente termos um ecossistema amplo e poderoso de IA nativa nos nossos dispositivos.

Sonhar não custa nada.

Notas de rodapé

- 1Central processing unit, ou unidade central de processamento.

- 2Graphics processing unit, ou unidade de processamento gráfico.

- 3Nos últimos anos, o treinamento de modelos por meio de GPUs virou uma espécie de padrão quando o assunto é IA, graças à velocidade com a qual as GPUs conseguem fazer cálculos simultâneos em comparação com CPUs. A NVIDIA foi a maior beneficiada disso, tendo valorizado mais de 200% em 2023.

- 4Estrutura de aprendizado de máquina usada em todos os produtos da empresa.

- 5Existe uma enorme discussão semântica sobre IA e ML no mercado e, tecnicamente, muito do que chamamos de IA é, na verdade, ML. Mas como picuinhas semânticas raramente chegam a algum lugar, sigamos em frente.