Mais um dia, mais uma rodada de explicações sobre os novos recursos da Apple contra abuso infantil. Agora, mais precisamente sobre o mais polêmico deles: a análise de hashes das fotos no seu iPhone/iPad (quando o Fotos do iCloud está ativado), que serão enviadas para monitoramento de possíveis conteúdos relacionados a pornografia infantil.

Em um documento liberado hoje [PDF], a Apple ofereceu a explicação mais técnica e completa sobre a tecnologia até o momento. A seção dedicada ao NeuralHash (nome técnico da tecnologia de detecção de CSAM1Child sexual abuse material.) também traz alguns dados novos — como o fato de que o sistema poderá, sim, ter auditoria pública.

Mais precisamente, quando o sistema começar a operar, usuários poderão verificar o hash raiz (root hash) da base de dados nos seus próprios dispositivos. Concomitantemente, a Apple publicará uma base de conhecimento com a root hash usada nas análises; com isso, usuários, pesquisadores de segurança e grupos pró-privacidade poderão verificar se as duas listas batem.

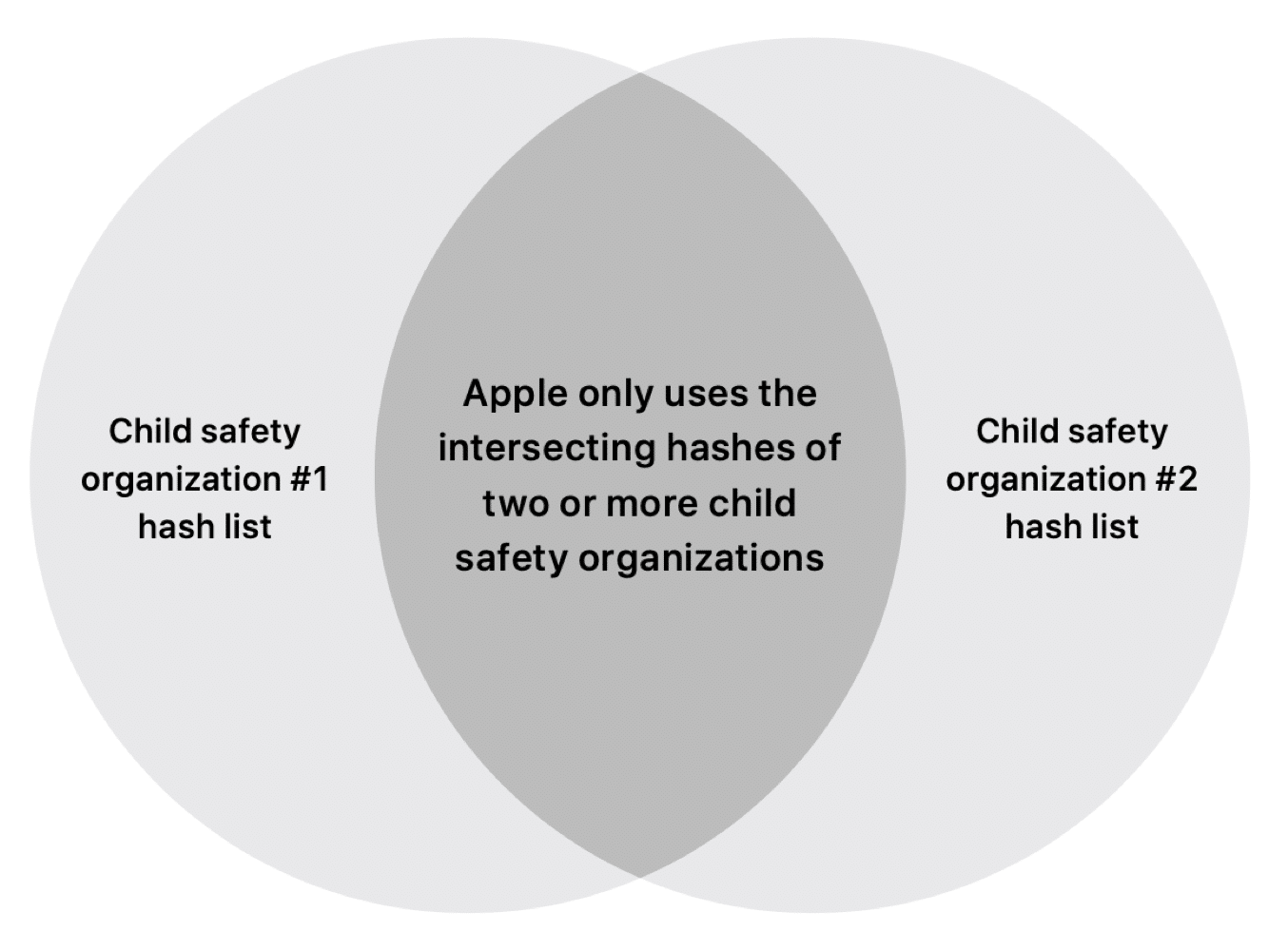

Isso é importante considerando como é formada a lista de hashes “proibidos”. Já se sabe que a Apple usará bases de dados de algumas organizações, com centenas de milhares de imagens conhecidas de pornografia infantil. A lista de hashes será constantemente atualizada e produzida a partir de uma interseção de duas ou mais bases de dados.

A auditoria, portanto, garantirá aos usuários e grupos que os hashes utilizados sempre virão das organizações de combate a abuso infantil, sem inclusões de hashes “irregulares”.

O documento da Maçã também detalha os dispositivos de segurança para evitar possíveis abusos do sistema — como um cenário hipotético no qual diferentes governos e organizações contra o abuso infantil se unissem para adicionar hashes não relacionados a CSAM no sistema. Neste caso, a equipe de análise humana da Apple verificará que usuários estão sendo marcados por fotos que não correspondem a conteúdo de abuso infantil e detectará o problema na lista de hashes, agindo de acordo.

Em relação ao sistema, já sabemos que ele tem um número mínimo de “detecções” antes de disparar o alerta para que a equipe de análise humana da Apple entre em ação. Este limite mínimo ainda não tinha sido divulgado, mas o documento revela que, inicialmente, o número será de 30 imagens — a Apple, entretanto, poderá alterar o valor com o avanço do sistema. A empresa garante que o número nunca ficará abaixo do valor exigido para que o NeuralHash mantenha sua taxa de erros em 1:1.000.000.000.000.

Todos os outros detalhes técnicos do sistema podem ser conferidos no documento, disponível nesse link [PDF].

Apple orientando varejo

Por mais que a Apple esteja incessantemente explicando e tirando dúvidas sobre seus novos recursos, a empresa sabe que pisou na bola na estratégia de lançamento deles e que os consumidores estão receosos e com dúvidas — o próprio Craig Federighi admitiu o erro numa entrevista hoje mais cedo.

Agora, segundo a Bloomberg, a Maçã está instruindo os empregados de suas lojas que se preparem para perguntas de clientes. Em um memorando distribuído entre o setor de varejo, a empresa pediu que funcionários leiam as documentações relacionadas aos novos recursos e se preparem para possíveis perguntas dos consumidores:

Você poderá receber perguntas sobre privacidade de consumidores que souberam dos nossos anúncios recentes sobre proteções expandidas para crianças. Este documento inclui uma seção de perguntas e respostas para lidar com essas questões e trazer mais clareza e transparência ao processo. Nós também adicionamos as principais perguntas sobre a detecção de CSAM abaixo. Por favor, tome seu tempo para analisar o conteúdo abaixo e o FAQ completo para que você possa ajudar nossos clientes.

Pelo visto, a força-tarefa de redução de danos da Maçã está se formando rapidamente. Será que vai ter resultado?

via MacRumors

Notas de rodapé

- 1Child sexual abuse material.