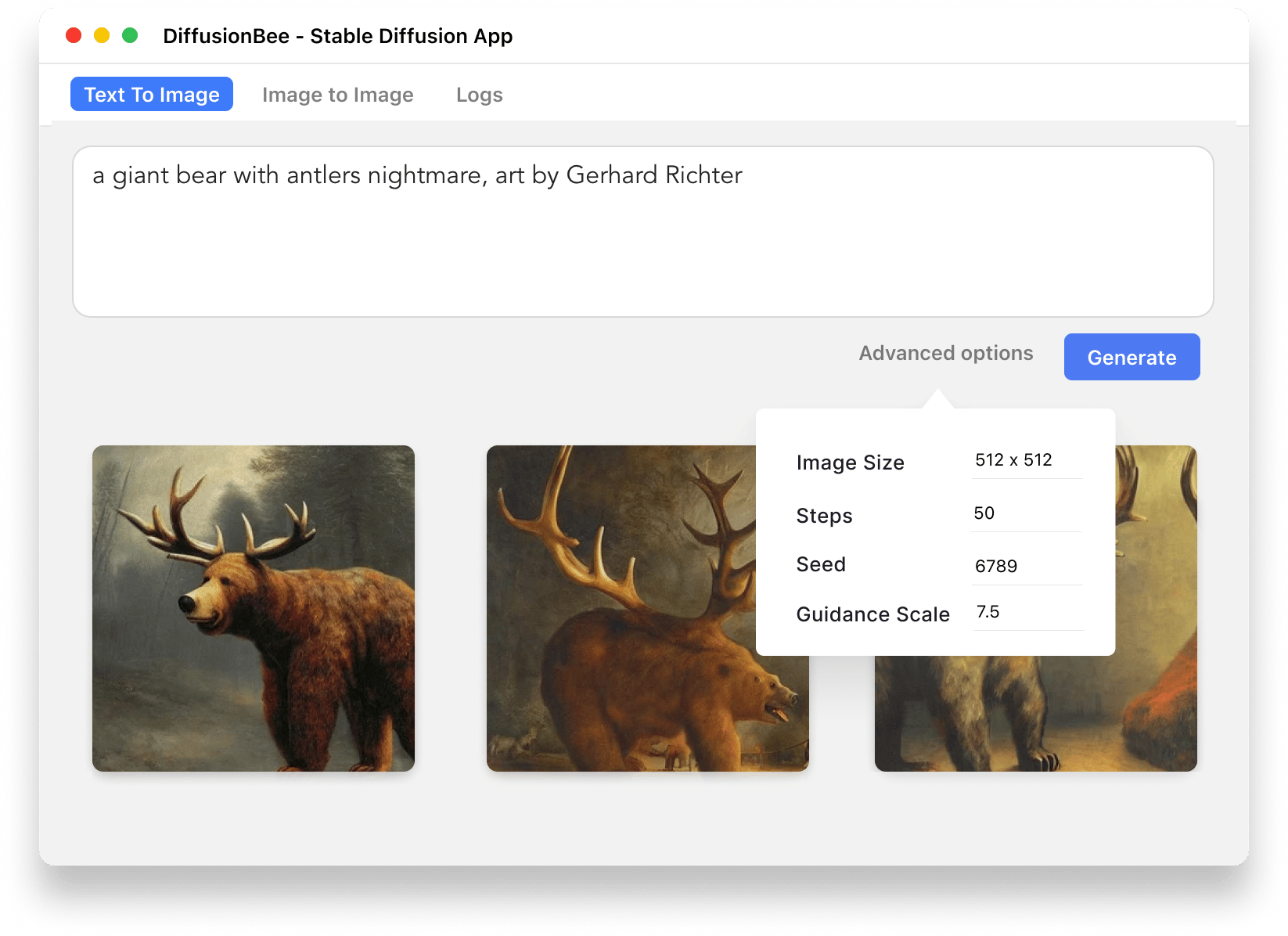

Uma das novas maravilhas da internet moderna, o Stable Diffusion colocou a equipe da Apple de desenvolvimento para trabalhar, especialmente para aprimorar o desempenho da inteligência artificial em máquinas rodando chips Apple Silicon.

A Maçã anunciou que otimizou o Core ML — estrutura de aprendizado de máquina usada em todos os produtos da empresa — para o Stable Diffusion no macOS 13.1, no iOS 16.2 e no iPadOS 16.2, que estão atualmente em fase beta.

Basicamente endossando o uso do gerador de imagens por inteligência artificial, a empresa acredita que sua implementação por meio de aplicativos é preferível em relação à baseada em servidores, já que mantém os dados fornecidos pelo usuário localmente no dispositivo. Os apps também dispensam o uso de internet uma vez que estão instalados.

De acordo com a Maçã, a otimização vem acompanhada com uma simplificação da conversão de modelos, o que facilita que desenvolvedores incorporem a tecnologia em seus aplicativos e que se obtenha um melhor desempenho em dispositivos com processadores M1/M2.

Dessa forma, o Stable Diffusion conseguirá aproveitar ao máximo as arquiteturas Neural Engine e GPU da Apple que estão presentes nos seus chips proprietários, resultando em uma geração de imagens incrivelmente rápida.

Um MacBook Air com chip M2 e 8GB de memória unificada, por exemplo, conseguiu completar 50 iterações e gerar uma imagem em menos de 18 segundos. Um iPad Pro com o chip M1, por sua vez, conseguiria fazer o mesmo trabalho em menos de 30 segundos.

Um baita avanço, não acham?

via MacStories